文章目录[隐藏]

在现代互联网环境中,网站加载速度已经不只是体验问题,而是直接影响用户留存、转化率以及搜索引擎排名的关键因素。

如果你发现自己的网站访问缓慢,或者在SEO排名上遇到瓶颈,谷歌推出的PageSpeed Insights(PSI) 就是你不可错过的优化神器。

什么是 PageSpeed Insights?

PageSpeed Insights(简称PSI) 是谷歌提供的一款网页性能测试工具,用于评估网页在真实用户和实验室环境下的加载性能,并给出可执行的优化建议。

PSI的核心特点:

- 同时分析桌面端(Desktop) 和移动端(Mobile)

- 结合真实用户数据(CrUX) 与实验室数据(Lighthouse)

- 覆盖性能、可访问性、最佳实践、SEO 四大维度

- 与Google排名算法中的Core Web Vitals深度绑定

如何使用 PageSpeed Insights?

使用步骤非常简单:

- 打开PageSpeed Insights官网:https://developers.google.com/speed/pagespeed/insights/

- 在输入框中填入你要分析的网站 URL。

- 点击 “分析”,等待几秒钟即可得到测试报告。

需要注意:PSI是按页面分析的,不是整站分析,不同页面的结果可能差异很大。

PageSpeed Insights报告结构说明

PSI报告默认分为移动设备和桌面设备:

两者评分标准一致,但由于网络环境和设备性能不同,移动端通常更难拿高分。

下面以桌面设备报告为例进行说明。

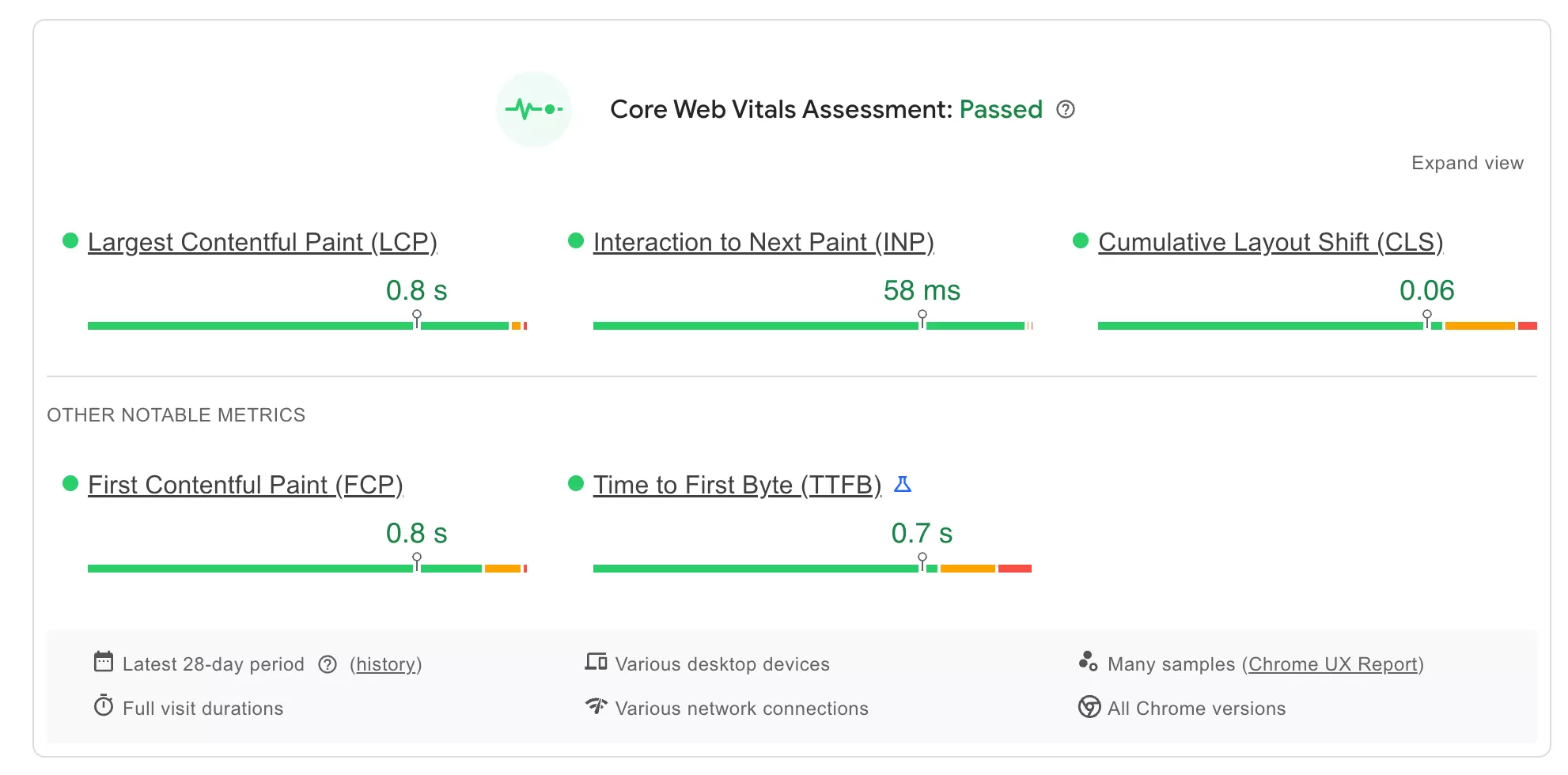

核心网络指标评估(Core Web Vitals Assessment)

Core Web Vitals(核心网页指标)是Google用来衡量真实用户体验的一组关键指标,并且已经明确作为排名信号使用。对应的Google Search Console(谷歌站长工具)的Core Web Vitals报告,可以用于监控网页的打开情况。

核心网页指标报告如:

Google对Core Web Vitals各指标的定义:

| 指标 | 英文全称 | 含义 | 理想标准 | 实际值 |

|---|---|---|---|---|

| LCP | Largest Contentful Paint | 页面主要内容加载完成时间 | ≤ 2.5 秒 | 0.8 秒 |

| FID | First Input Delay | 用户首次交互的响应延迟 | ≤ 100 毫秒 | 58 毫秒 |

| CLS | Cumulative Layout Shift | 页面布局稳定性(防跳动) | ≤ 0.1 | 0.06 |

| TTFB | Time To First Byte | 服务器首字节响应时间 | ≤ 0.8 秒 | 0.8 秒 |

| FCP | First Contentful Paint | 首个可见元素渲染时间 | ≤ 1.8 秒 | 0.7 秒 |

从上表可以看到,该网站的核心网络指标全部达标。

如果你的网站的指标超过上述理想标准,建议优化它。

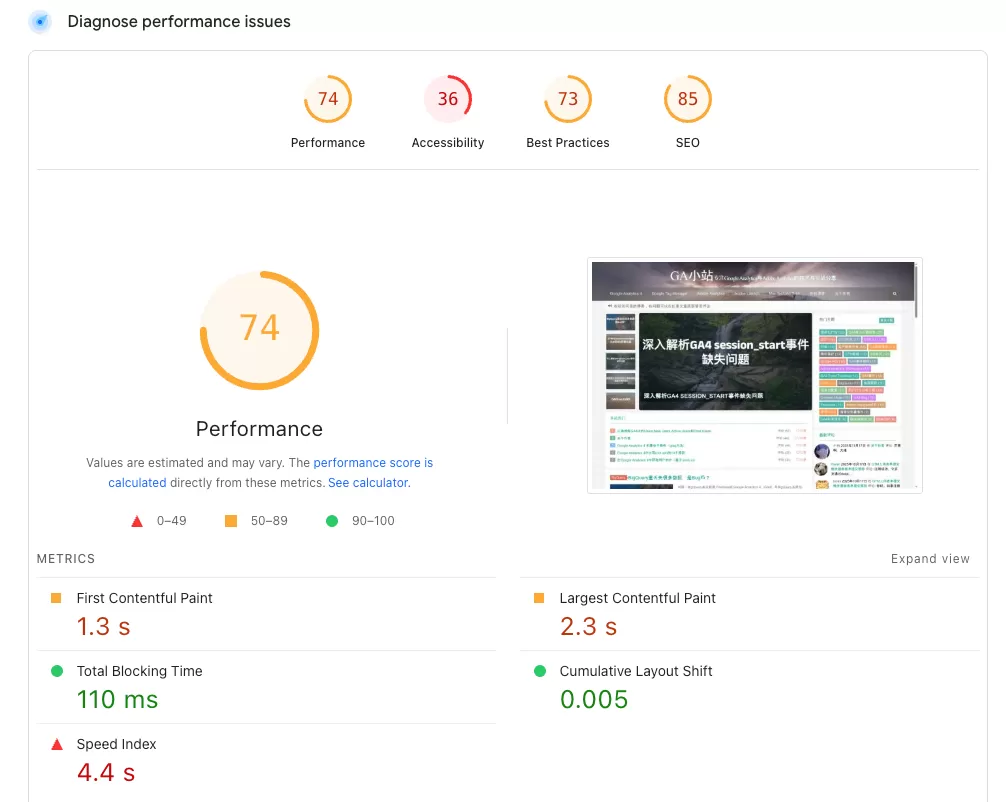

诊断性能问题(Diagnose performance issues)

这个分数是Lighthouse performance scoring,这个数值是通过图中实验室数据计算出来的,分数越高,表示越好。

这个网站的整体得分如下:

- Performance(性能):74(橙色,良好但仍有优化空间)

- Accessibility(可访问性):36(红色,较差,急需改进)

- Best Practices(最佳实践):73(橙色,一般)

- SEO(搜索引擎优化):85(橙色,良好但仍有优化空间)

Lighthouse 关键性能指标解析:

| 指标 | 英文全称 | 含义 | 理想标准 | 实际值 |

|---|---|---|---|---|

| FCP | First Contentful Paint | 首个可见元素渲染时间 | ≤ 1.8 秒 | 1.3 秒 |

| LCP | Largest Contentful Paint | 页面主要内容加载完成时间 | ≤ 2.5 秒 | 2.3 秒 |

| CLS | Cumulative Layout Shift | 用户首次交互的响应延迟 | ≤ 0.1 | 0.005秒 |

| TBT | Total Blocking Time | 累积布局偏移 |

200ms

|

110ms |

| Speed Index | Speed Index | 服务器首字节响应时间 | ≤3.4秒 | 4.4 秒 |

性能指标整体尚可,Speed Index偏高,可访问性与最佳实践问题拉低了整体评分。

多测试几个页面,看是偶发,还是一直存在偏高。

优化建议(Opportunities & Diagnostics)

在PSI报告下方,你可以直接看到Google给出的具体优化建议,例如:

这些建议的最大优点是:不是泛泛而谈,而是直接告诉你“该改哪里”

这些建议的最大优点是:不是泛泛而谈,而是直接告诉你“该改哪里”

PageSpeed Insights 实战优化技巧汇总

| 优化方向 | 具体措施 |

|---|---|

| 压缩和优化图片 | 使用WebP或AVIF格式替代传统 JPG/PNG;设置合理图片尺寸,避免加载过大的图片 |

| 启用浏览器缓存 | 对静态资源(CSS、JS、图片)设置合理的缓存策略,减少重复加载 |

| 减少不必要的 JavaScript | 延迟加载(lazy load)或异步加载(async/defer)脚本,降低阻塞渲染 |

| 启用GZIP或Brotli压缩 | 压缩网页文件,减少数据传输大小,提高加载速度 |

| 优化服务器响应时间 | 使用CDN加速资源分发;优化数据库查询和后端逻辑,提高首字节时间(TTFB) |

| 减少重定向次数 | 避免多次跳转,直接访问最终URL,提高访问效率 |

总结:如何正确看待PSI分数?

分数不是最终目的,Core Web Vitals才是SEO的核心:Lighthouse用来找问题,CrUX用来看真实体验。

持续优化PSI,本质上是在同时优化用户体验+SEO排名。